COLUMN - Elon Musk, de alom bewonderde visionair die vorige week met veel zinloos geweld een auto de ruimte in schoot, waarschuwde vorig jaar voor een enorm gevaar dat onze beschaving ten onder zou doen gaan. Nee, niet het broeikaseffect of Donald Trump – hij had het over Artificial Intelligence. AI. Nu zijn auto met die malle pop achter het stuur uit het zicht verdwenen zijn, is het wellicht aardig die claim eens tegen het licht te houden.

AI gaat de wereld veranderen. Zo beweren velen. Maar het is altijd verstandig om dat soort uitspraken in hun context te zien. En dat is de context van wetenschappers en ondernemers op zoek naar investeerders. Musk behoort daarbij tot de minderheid die vooral ellende verwacht. Maar ook hier is de context van belang. Goeroes willen diepzinnig zijn, dus tegendraads.

Wat is Artificial Intelligence? Meestal gaat het dan om een machinale ‘intelligentie’ ontwikkeld door middel van Deep Learning. Die aanduiding komt van de bovengenoemde wetenschappers en ondernemers. En u raadt het dus al, erg deep is dat leren niet.

Het komt erop neer dat je een chaotisch netwerk van verbindingen en knooppunten (knooppunten die signalen kunnen versterken dan wel verzwakken) ontelbare malen voedt met input aan de ene kant en de gewenste output aan de andere kant. In eerste instantie levert de input aan de output-kant alleen maar onzin op, maar door steeds weer daarna de gewenste output vanaf de output-kant in te laten stromen (backpropagation) ‘leert’ het netwerk voorbeeld-na-voorbeeld om later bij input spontaan de gewenste output te leveren. Duizenden plaatjes van auto’s (met als opgelegde output het woordje ‘auto’) leveren zo uiteindelijk een netwerk dat bij een nieuw autoplaatje ‘spontaan’ het woordje ‘auto’ uitspuugt. Het heeft geleerd. Niet deep, maar toch. Uiteindelijk kan zoiets heel snel, en kan het netwerk het menselijk brein overtreffen. Menig bordspel is inmiddels het domein van Artificial Intelligence.

Gaat AI de wereld veroveren? Krijgen we straks computers die ons al het werk uit handen gaan nemen, en ook nog beter zijn dan wij, Homo sapiens? Gaan we de auto van Musk achterna? Gary Marcus van de New York University zette niet zo lang geleden zijn twijfels eens op een rijtje. Deep Learning, zo schrijft hij, stuit onvermijdelijk, en waarschijnlijk al binnenkort, op een aantal onneembare barrières. Hij noemt de techniek gulzig, breekbaar, ondoorzichtig en oppervlakkig.

Gulzig, want het werkt alleen maar als je eerst enorme hoeveelheden data aanlevert. Waar een mens met een paar aanwijzingen volstaat, moet een AI-systeem dat ‘auto’ kan zeggen voor ‘bestelbus’ weer door de hele leermolen.

Breekbaar, want bij echte twijfelgevallen valt het systeem volkomen stil. Het heeft één ding geleerd, of een beperkt aantal dingen, en kan niet improviseren. Niemand kan voorspellen wat de AI-auto op de snelweg kan tegenkomen. En wat hij dan dus gaat doen.

Ondoorzichtig, want geen buitenstaander weet hóé de draadjes precies verbonden zijn en tot hun conclusie komen. De ingebouwde risico’s zijn onbekend.

En tot slot oppervlakkig want ze weten in feite niets. Niet waar ze mee bezig zijn, geen context, geen inzicht, geen empathie. Ook dat kan de gebruiker ernstig opbreken.

Marcus’ kritiek is natuurlijk niet nieuw. En natuurlijk zijn er deskundigen die hun hart en ziel (en hypotheek) verkocht hebben aan de gouden toekomst van Artificial Intelligence, en die de bezwaren wegwuiven. Ze zeggen dan vaak dat dergelijke hobbels genomen kunnen worden door steeds méér verbindingen toe te voegen, door het systeem complexer te maken. Dan gaat de computer straks écht denken als een mens! Nee, zegt Marcus, Het gaat hier om fundamentele problemen inherent aan de techniek. Méér systeem verandert het systeem niet. Net zoals reuzegrote raketten geen zinvolle ruimtevaart opleveren.

Reacties (14)

Waar men bang voor is dat er een soort singulariteit komt en dat we AI helemaal uit de hand loopt. Goed geïllustreerd door onderstaand verhaal:

https://www.reddit.com/r/shortscifistories/comments/2uzdhm/we_love_our_customers_robotica/

Ikzelf ben er niet zo bang voor. De meesten denken dat intelligentie in een cognitief iets is, maar ik denk veeleer dat het een emotioneel iets is (onderbuik).

Wel interessant is te lezen over de AlphaZero en de vorderingen die er gemaakt zijn op IA gebied. Het staat zeker niet stil

http://www.zdnet.com/article/deepmind-alphago-zero-learns-on-its-own-without-meatbag-intervention/

https://www.theguardian.com/technology/2017/dec/07/alphazero-google-deepmind-ai-beats-champion-program-teaching-itself-to-play-four-hours

Dit betoog is zo’n beetje zoiets van: “Ja een elektrische auto dat gaat nooit wat worden want ik heb een RC-auto op een batterij en die doet het ook maar 20 minuten.”

Vervang “elektrische auto” door “artificial general intelligence” en “RC-auto” door “deep learning”. Deep Learning is hoogstens een onderdeel van AGI en de limieten daarvan zullen hoogstens de limieten van een onderdeel zijn. Limieten die in mijn voorbeeld van de elektrische auto onoverkomelijk leken, maar met “HEEL VEEL” gewoon op te lossen bleken.

Verder kun je je afvragen in hoeverre de afhankelijkheid van grote datasets voor Deep Learning nou zo’n probleem is; wij mensen verwerken toch al gauw een tiental beeldjes per seconde en doen dat ongetwijfeld en passant ook nog eens voor allerlei onderdelen van die beeldjes. Zijn mensen niet net zo afhankelijk van grote hoeveelheden data? Spelen wij die moeilijke turnoefening niet al dan niet bewust ook 100 keer in onze ingebouwde simulator af voordat het lukt? Maken wij niet precies dezelfde fouten als Deep Learning oplossingen als we geconfronteerd worden met voor ons volstrekt onbekende beelden of woorden? Volgens mij wel. We zijn alleen nogal geneigd om onszelf als significant meer te zien dan we wellicht blijken te zijn als we het eindelijk door hebben.

Daarmee is het antwoord op het gapende gat tussen de huidige stand van zaken AGI natuurlijk/gelukkig nog niet gedicht, maar dat is bepaald geen reden om je er geen zorgen om te maken; het wachten is waarschijnlijk slechts op de slimme en achteraf wellicht ogenschijnlijk voor de hand liggende combinatie van vele onderdelen, processorcapaciteit en de tijd die nodig is om zo’n ding ook echt iets anders te leren dan een flauw getagde set van plaatjes. Want, laten we wel wezen, de tekortkomingen van Deep Learning die veelal worden beschreven liggen veel meer verborgen in de (door beperkte processorcapaciteit ingegeven) aanpak en toepassing dan in inherente beperkingen van Deep Learning.

En dat je een psycholoog/neuroloog als voorbeeld aanhaalt is natuurlijk een beetje net als wijzen naar een econoom in de klimaatwetenschap :p Niet dat ik Gary Marcus als anti-wetenschappelijk wil kenmerken; dat is hij niet, hij is vooral de advocaat van de duivel, de luis in de pels, de steller van moeilijke vragen en de brenger van nuances. Maar een wetenschappelijk expert op dit vlak is hij gewoon niet, ook al lijkt dat wellicht zo omdat ie er leuk over kan vertellen.

AI zal nooit kunnen leren van de onderliggende motieven achter de humor/ satire. Zowel qua vorm als inhoud. Het zal in de ontstane chaos daarna in volslagen verwarring en verbijstering achterblijven tot de conclusie komen dat het geen bestaansrecht meer heeft en uiteindelijk onvermijdelijk tot zelfvernietiging overgaan. Tenminste: als je daarvoor verder geen andere “commando’s” hebt gegeven..

Het probleem met Hulspas is dat zijn eigen intelligentie zo dicht bij AI staat – kennis en niveau – dat hij niet begrijpt hoe ver AI eigenlijk al gekomen is en waar we sinds het begin van de (Von Neumann) computer zijn gekomen. De angst springt Hulspas blijkbaar om het hart en dan is ontkenning (vgl klimaatwetenschap) de heilige weg te gaan blijkbaar (al laat hij zijn twijfel door Marcus verwoorden). Iedereen die zegt: ‘zal nooit kunnen’ en die niet al met een been in het graf staat, zal nog mooie dingen gaan zien. Ik heb in elk geval een weddenschap lopen, dat AI-bestuurde auto’s over vijf – nee, dat is al vier – jaar realiteit zijn. Ik zie geen apocalyptiek in AI, zeker niet die van Musk, en zie geen twijfel als Marcus. AI gaat zeer belangrijk zijn in ons leven en dat je AI beter niet kunt onderschatten, lijkt me evident. Gewoon vanuit de evolutionaire weg.

@4 AI-bestuurde auto’s zijn toch al lang een realiteit? Je kunt ze – afgezien van de Tesla’s en wat andere “rij-hulpen” – alleen nog niet kopen, maar dat heeft meer met juridisch geneuzel te maken dan met de stand der techniek.

Rare verhalen, die mij volkomen van de leg brengen. Toen Deep Blue de wereldkampioen schaken versloeg, was dat een triomf voor AI, of brute rekenkracht, die artisticiteit versloeg?

Jan Hein Donner kreunde in zijn graf.

Elon Musk brengt een Tesla in een baan om de zon: is dat een overwinning voor de technologische almacht of een absurdistische wandaad tegen de mensheid? Zouden die dollars het niet beter doen op het nog steeds in puin liggende Haïti?

Van mij mogen de nerds lekker prutsen aan hun apparaten. Het gevaar komt niet van hen, maar van degenen die er over na zouden moeten denken.

@6: “was dat een triomf voor AI, of brute rekenkracht, die artisticiteit versloeg?”

“is dat een overwinning voor de technologische almacht of een absurdistische wandaad tegen de mensheid?”

Dat zijn schijntegenstellingen.

@5: Juridisch geneuzel is uiteindelijk vooral een codificatie van maatschappelijke (niet)acceptatie. AI kan veel meer dan wat we op dit moment willen (of kunnen betalen).

@6 DeepBlue vs. Kasparov ligt alweer twintig jaar achter ons. Het gemiddelde schaakprogramma op je mobieltje heeft al meer rekenkracht. Maar dat is allemaal brute force inderdaad.

Interessante is dat een subdivisie van Google een AI heeft ontwikkeld, AlphaGoZero, dat zichzelf in een paar uur schaken heeft geleerd, en inmiddels de sterkste brute force schaakcomputers verslaat.

Schakers kijken er naar met een mengeling van verwondering en afschuw, want enerzijds biedt het een leerinstrument (AlphaGoZero is waarschijnlijk de sterkste schaker aller tijden), maar anderzijds vernauwt deze technologie het schaken ook: er valt minder te wikken en te wegen over wat de correcte zet is.

Vraag die ik nog wel heb: als Google in staat is om een zelflerende AI zichzelf in een paar dagen/weken tijd van schaakn00b tot internationaal grootmeester te ontwikkelen, waarom leveren Google’s vertaalmachines nog altijd zulke povere resultaten op?

Interessant is de vraag of de openingsstijl van AlphaGoZero afwijkt van de bekende Nimzo-Indisch, Spaans enz.

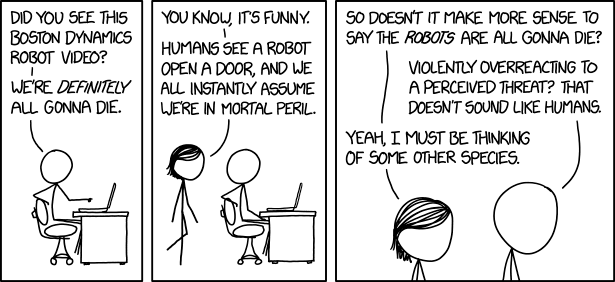

xkcd is vandaag erg passend:

Een schaakwedstrijd is een metafoor voor het leven: we hopen door intelligente zetten te doen te ‘winnen’ (zo gezond en gelukkig mogelijk zo oud mogelijk te worden). In die zin is een AI een hulpmiddel bij toekomst-voorspelling.

Maar we hebben al relatief goede toekomstvoorspellers: het verzekerings-wezen, de beurs en marketing-branche. Ik zou zeggen: laat zo’n AI het opnemen tegen dit soort gasten.

@9

Taal heeft geen wiskundige basis (althans niet op een niveau waar wij nog een computer wiskundige waarden aan kan hechten). Het indirecte, contextuele geheel die een tekst voor ons zijn betekenis geeft is voor een computer onvatbaar, een computer kan enkel equivalenten als zijnde lege symbolen voor woorden geven. Een computer vertaald een tekst zoals jij een Koreaanse tekst in het Swahili zou vertalen afgaand op een woordenboek Koreaans-Swahili. Hoeveel Koreaanse en Swahili teksten jij of een zelflerende computer ook voorgeschoteld krijgen, de betekenissen van de woorden vallen er niet uit te herleiden.

@9:

Is het aantal variaties in taal niet 1. veel groter en 2. diffuser? Ik opper maar wat hoor, maar gevoelsmatig komt het me niet zo gek voor dat die Babelfish erfgenamen nog altijd matige resultaten opleveren.

Edit: Ik zie net dat mijn voorganger het veel beter formuleert.